VC Dimension

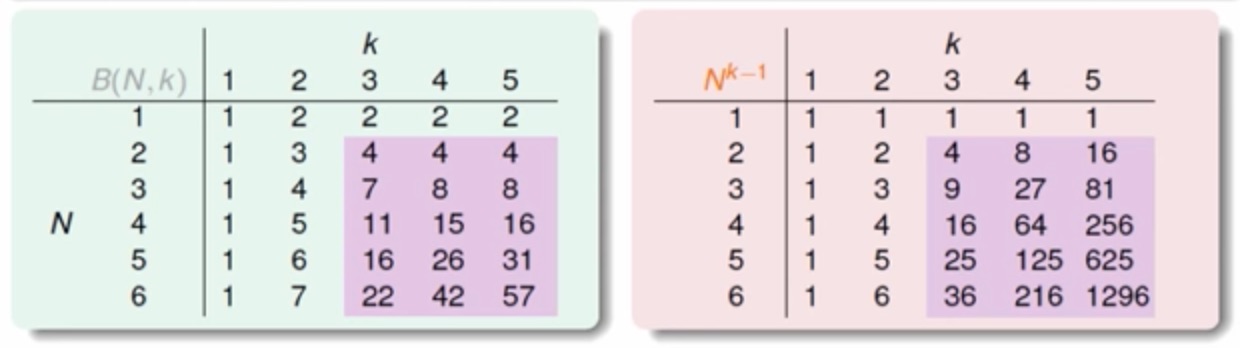

VC Dimension () = 'minimum K' -1

透過上圖可以簡化我們的式子

透過上圖可以簡化我們的式子

機器學習的條件

- Good Hypothesis Set (有 Break Point)

- Good Data (N 夠大)

- Good Algorithm (可以挑到夠小 的 Hypothesis)

- Good Luck

VC Dimension for d-D Perceptron

- 1-D perceptron:

- 2-D perceptron:

- d-D perceptron:

Proof

Step 1. 證明

證明的方式就是要證明當 x 為 d 維度時, d + 1 個 output 可以被 shattered

設計一個特殊矩陣, 表示將 d+1 個 input 組成一個 X 矩陣 (X 反矩陣存在 invertible) 根據定義

For any y, sign (Xw) = y, 那我們試著找一個 w 使得 Xw = y (假設存在這麼剛好的 X)

由前提知設計出的X 反矩陣存在, 所以 w = X-1y 也會存在, 得證存在某個 hypothesis w 使得任意 y 都可以被產生出來 (Shattered)。

Step 2. 證明

證明的方式就是要證明當 x 為 d 維度時, d + 2 個以上的 output 都不能被 shattered

將之前設計的矩陣加入第 d+2 筆的 input 則 因為線性相依的關係 (d+1 維, 且 前 d+1 筆資料是線性獨立, 第 d+2 筆肯定能由前 d+1 筆向量組合而成)

假設 d+2 種 output 都能被 shattered 的話, 那麼 d+1 種的 output 也要能被 shattered, 所以此時我們假設存在 w 可以使得 , 因為與係數同向也僅是其中一種 output y (Shatter 理應要存在)

(恆成立)

所以至少有一種是無法被產生出來的 output, 那就是以上的 case 搭配上 < 0 (反證法得證)。

Degrees of Freedom (自由度)

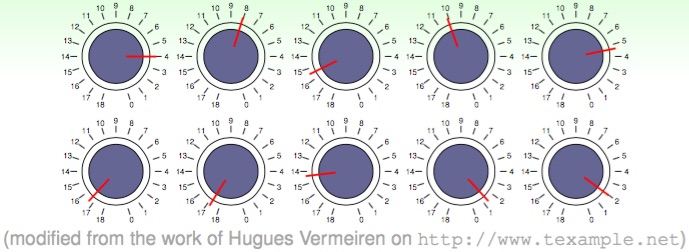

VC dimension 代表的意思是 Hypothesis Set 裡的自由度, 雖然上面這些可控制的旋鈕 (假設是類比) 有無限多種組合, 但 是著眼真正有效的 (Effective Number of Lines) 種類有多少 (意涵對相同 input 可產生出不同結果)。

VC dimension 代表的意思是 Hypothesis Set 裡的自由度, 雖然上面這些可控制的旋鈕 (假設是類比) 有無限多種組合, 但 是著眼真正有效的 (Effective Number of Lines) 種類有多少 (意涵對相同 input 可產生出不同結果)。

複雜度評估

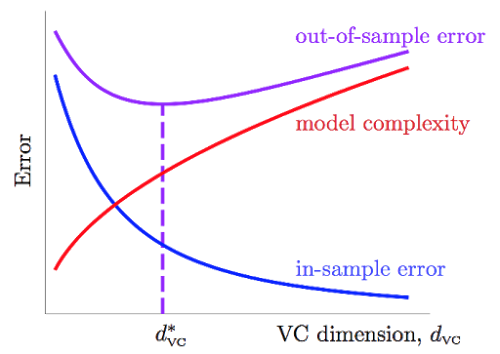

將右式定義為 , 移項可得

重新定義 , 稱作 Penalty for Model Complexity (Model 是指 hypothesis, 而這個 penalty 就是指在我們要有多強的 Hypothesis Set 時, 所需付出的代價)

筆者按:筆者的理解, 是說今天這個不等式觀察的角度如果將重心放中, 目標希望 發生壞事情的機率降低到某個門檻, 此時 Learning Model 的 與 的距離關係。(只是將不等式鎖定的變量代換而已)

- best

透過上式可以了解, 並非一昧地追求 VC dimesion 愈大愈好, 而另一個使用 VC bound 的方式, 是用來侷限資料量 稱 Sample Complexity, 當今天目標鎖定了 我們究竟需要多少的 input 才能達到符合 的目標。

, , 迭代不同的 所求出的關係式

但是通常 實務上已足夠。(也隱含著 VC Bound 實際上是相當寬鬆不精準的上限)

Summary

目前透過數學工具的推導, 我們了解到了兩件事情

第一件事

Linearly Separable Data

PLA can converge (推導出 與 迭代次數 成正比)

if T enough large

第二件事

with xn ~ P and yn = f (xn)

by is finite (此章節推廣至 d-D perceptron 也成立)

if N enough large